|

PLM ist das Fundament für die digitale TransformationVon Bernd Pätzold Ohne ein robustes PLM-Fundament kann die digitale Transformation von Geschäftsprozessen und -modellen nicht gelingen. Deshalb finde ich es besorgniserregend, dass viele Unternehmen ihre Digitalisierungs- und IoT-Strategien unabhängig von PLM definieren, wie die Markstudie PLM Pulse 2017 ergeben hat. Offensichtlich müssen wir hier noch mehr Überzeugungsarbeit leisten: Future PLM ist Chefsache, wie das Future PLM-Thesenpapier des prostep ivip Vereins ganz richtig postuliert.

Die digitale Revolution transformiert Wirtschaft und Gesellschaft in den unterschiedlichsten Bereichen, vom Wohnungswesen über die Mobilität bis zur Gesundheitsversorgung. Für die Unternehmen der Fertigungsindustrie bedeutet diese Revolution in dreifacher Hinsicht eine Herausforderung: Erstens müssen sie ihre Entwicklungsprozesse und -methoden überdenken, um den neuen Anforderungen bei der interdisziplinären Entwicklung smarter Produkte und Systeme Rechnung zu tragen. Stichwort Systems Engineering. Zweitens müssen sie ihre Produktion fit für Industrie 4.0 und die autonome Fertigung machen, um kundenindividuelle Produkte auch noch in Losgröße eins effizient produzieren zu können. Und drittens müssen sie ihre Service-Prozesse besser mit Engineering und Produktion integrieren, um den Produktlebenszyklus bis in die Betriebsphase unterstützen und ihren Kunden auf Basis des Internet of Things (IoT) neue Service-Angebote offerieren zu können. Der Hype um IoT und Industrie 4.0 führt dazu, dass das etwas in die Jahre gekommene Thema PLM vernachlässigt wird. Ohne ein robustes PLM-Fundament mit sauberen Produktdaten ist die digitale Transformation der Fertigungs- und Service-Prozesse auf Sand gebaut. Das haben zahlreiche Vorträge auf der PI PLMx in Hamburg unlängst wieder deutlich gemacht. Wenn ich in diesem Zusammenhang von PLM rede, meine ich nicht eine bestimmte Systemlösung, sondern das Konzept des Product Lifecycle Managements. Es ist durch das IoT nicht obsolet geworden – im Gegenteil: Die Vernetzung von smarten Produkten und Systemen über das Internet bietet überhaupt erst die Möglichkeit, die Betriebsphase mit Hilfe von Digital Twins zu unterstützen und dadurch den PLM-Gedanken bis zum Ende des Produktlebens zu denken. Oder anders ausgedrückt, den Produktlebenslauf im Sinne eines Closed Loop zu schließen und die Informationen aus der Betriebsphase wieder für die Entwicklung der nächsten Produktgeneration zu nutzen.

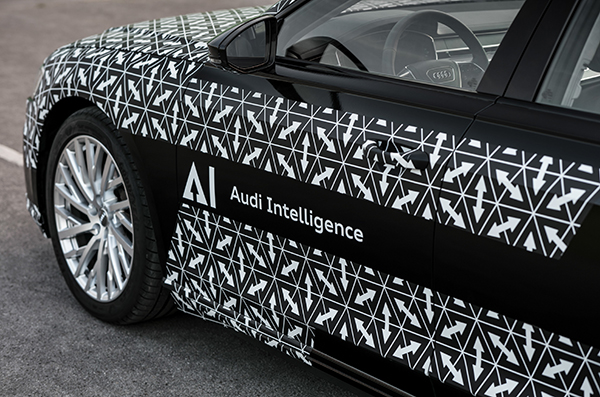

Es geht also nicht darum, neue Namen für PLM zu erfinden, sondern PLM neu zu definieren. Die Unterstützung von Themen wie Systems Engineering, Industrie 4.0 oder IoT erfordert eine andere Art von PLM-Architektur als wir sie kennen. Monolithische Systeme sind zu schwerfällig, um agil auf die neuen Anforderungen eines verlängerten Produktlebens reagieren zu können. Das kommt in den Future PLM Thesen, die PROSTEP zusammen mit anderen PLM-Experten aus Industrie und Forschung im Rahmen des prostep ivip Vereins formuliert hat, klar zum Ausdruck. Wir brauchen stattdessen modulare PLM-Architekturen mit förderierten Systemen und intelligent vernetzten Informationen. Grundvoraussetzung dafür ist Offenheit, wie sie der Code of PLM Openness (CPO) einfordert. In die Future PLM-Thesen sind Erfahrungen aus mehr als das 20 Jahren PLM-Praxis eingeflossen, und sie haben durchaus einen praktischen Nutzen für die Unternehmen. Automobilhersteller Audi dienten sie als Orientierungshilfe für die Neugestaltung seiner PLM-Landschaft und -Prozesse auf dem Weg zum Systems Engineering. Im Interview erläutert Thomas Kriegel, Leiter Prozess-und Methodenentwicklung Systems Engineering bei Audi, einige der Handlungsanleitungen, die das Unternehmen aus den Thesen abgeleitet hat, und unterstreicht die Bedeutung der Offenheit für die Gestaltung der PLM-Systemlandschaft. Audi denkt auch über neue Konzepte nach, wie die Daten in den unterschiedlichen Systemen miteinander verlinkt werden können. Mit der Verlinkung ist es jedoch nicht immer getan. Um die digitalen Daten über den gesamten Lebenszyklus effizient nutzen und wieder verwenden zu können, müssen sie in vielen Fällen erst einmal bereinigt und vervollständigt werden. Die Qualität der Informationsmodelle ist der Schlüssel zur Digitalisierung der Informationsflüsse und Geschäftsprozesse. Nicht alle diese Informationen werden künftig mit den klassischen PLM-Systemen verwaltet, aber sie spielen eine zentrale Rolle für die Qualifizierung der Ursprungsdaten.

Das gilt im Übrigen auch für die Qualifizierung der (mechanischen) CAD-Modelle, die aufgrund des wachsenden Elektronik- und Softwareanteils in unseren smarten Produkten lange Zeit etwas vernachlässigt worden ist. Gerade die neuen Themen wie Additive Manufacturing oder Digital Thread führen jetzt dazu, dass die Unternehmen sich wieder mehr Gedanken darüber machen, wie sie ihre digitalen Produktmodelle aufbauen müssen, um sie optimal auslegen und prozessdurchgängig nutzen zu können. Die gute, alte Konstruktionsmethodik hat deshalb nicht ausgedient, wie der Beitrag von Hartwig Dümler im Newsletter zeigt. Ich wünsche Ihnen viel Spaß bei der Lektüre. |

|

| © PROSTEP AG | ALL RIGHTS RESERVED | IMPRESSUM | DATENSCHUTZERKLÄRUNG | HIER KÖNNEN SIE DEN NEWSLETTER ABBESTELLEN. |